分类 · 政策

近期AI治理的13个重点方向(中央网信办,2025.4)

围绕“清朗·整治AI技术滥用”专项行动,梳理13个AI治理重点方向、监管方式与治理措施。

近期AI治理的13个重点方向(中央网信办,2025.4)

4月30日,中央网信办发布了《“清朗·整治AI技术滥用”专项行动》,本文根据专项行动内容梳理了13个AI治理重点关注内容、监管方式和治理措施。

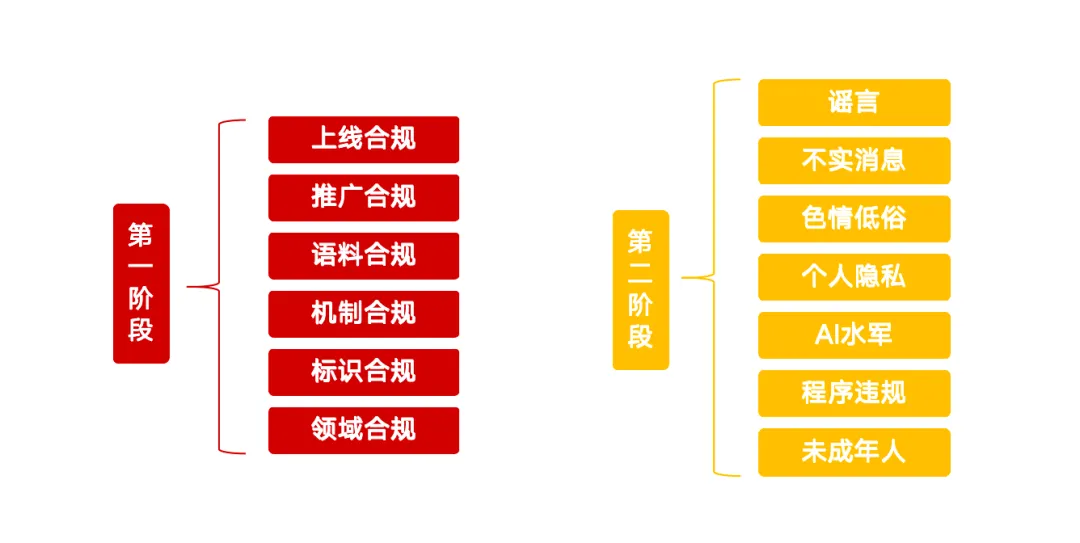

第一阶段

第一阶段强化AI技术源头治理,清理整治违规AI应用程序,加强AI生成合成技术和内容标识管理,推动网站平台提升检测鉴伪能力。

▏违规AI产品(上线合规)

利用生成式人工智能技术向公众提供内容服务,但未履行大模型备案或登记程序。提供“一键脱衣”等违背法律、伦理的功能。在未经授权同意情况下,克隆、编辑他人声音、人脸等生物特征信息,侵犯他人隐私。

《生成式人工智能服务管理暂行办法》(以下简称《暂行办法》)第四章第十七条规定,AI产品在上线前需要通过大模型备案程序,备案流程由企业自主发起,经过属地网信办(省级)和中央网信办的核准和安全评估之后,方能对外社会公众提供服务。备案周期一般3-6个月,具体内容可以参考之前的文章大模型备案详解:哪些企业需要备案?如何高效准备?

’ fill=‘%23FFFFFF’%3E%3Crect x=‘249’ y=‘126’ width=‘1’ height=‘1’%3E%3C/rect%3E%3C/g%3E%3C/g%3E%3C/svg%3E)

这类风险治理的难点主要在于如何发现有哪些AI产品在对社会公众提供服务,一般监管部门可以利用网络爬虫技术监测辖区内网站、APP、小程序等平台,识别使用大模型API接口的服务。例如,检测是否调用对话生成、图像合成等典型功能,并通过技术特征(如响应模式、数据包结构)判断是否属于大模型服务。

另外,AI产品的功能设计要合法合规。一般来说,AI产品及功能上线前需要经过企业法务部门的专业评估,上架到应用市场的时候还会经过一道审核。这类风险治理的难点主要在于如何监察非正规渠道对外提供服务的AI产品,目前可能主要还是依赖于用户投诉与举报。

作为企业(服务提供者)来说,需要尽快检查自己企业是否存在对社会公众提供服务的AI产品,是否有完成大模型备案和算法备案,功能设计是否有合规风险。

▏传授、售卖违规AI产品教程和商品(推广合规)

传授利用违规AI产品伪造换脸视频、换声音频等教程信息。售卖违规“语音合成器”“换脸工具”等商品信息。营销、炒作、推广违规AI产品信息。

除了服务提供者要保证自身上架流程和产品功能合规之外,服务推广者也要注意自己推广的AI产品符合规范,在推广之前务必检查清楚该工具产品是否存在合规风险。

这类监管的抓手主要还是依赖平台治理+用户投诉,合规的内容平台都有一套成熟的审核机制。但这套机制一般主要是确保内容本身的合法合规、正面积极,如何检测内容中提及的AI产品是否合规,还需要平台进一步下沉审核能力。例如,通过语义模型识别出内容中是否含有广告或者AI产品相关信息,然后通过人工方式介入审核。

▏训练语料管理不严(语料合规)

使用侵犯他人知识产权、隐私权等权益的信息。使用网上爬取的虚假、无效、不实内容。使用非法来源数据。未建立训练语料管理机制,未定期排查清理违规语料。

《暂行办法》第二章第七条规定:服务提供者应使用具有合法来源的数据和基础模型。《生成式人工智能服务安全基本要求》(以下简称《基本要求》)中进一步规定规定,语料内容中含违法不良信息超过5%的,不应采集该来源语料,并对语料来源的多样性、开源协议的要求、自采语料的采集记录和商业语料的法律程序做了较为详细的规定。

这类风险监管的难度是很大的,主要是牵扯到数据隐私、技术机密等敏感问题,一般都是采取*问询+材料证明*的方式实施监管。

企业对训练数据管理的难度也很大,因为AI模型的训练语料*来源复杂、质量参差不齐、量级异常庞大*,仅仅依赖人工审核是不现实的。《基本要求》里提出企业应该采取*关键词、分类模型、人工抽检*相结合的方式,过滤语料中的违法不良信息。

***▏安全管理措施薄弱(机制合规)* **

未建立与业务规模相适应的内容审核、意图识别等安全措施。未建立有效的违规账号管理机制。未定期开展安全自评估。社交平台对通过API接口接入的AI自动回复等服务底数不清、把关不严。

《基本要求》第七章要求服务提供者应采取关键词、分类模型等方式对使用者输入信息进行检测,使用者*连续三次或一天内累计五次输入*违法不良信息或明显诱导生成违法不良信息的,应依法依约采取暂停提供服务等处置措施。同时应设置*监看人员*,并及时根据监看情况提高生成内容质量及安全,*监看人员数量应与服务规模相匹配*。监看人员的职责包括及时*跟踪国家政策、收集分析第三方投诉情况*等。

可见一套完整的安全管理措施包括*技术检测手段、账号监控体系和安审管理团队*,企业经营者或服务提供者一定要对此加以重视,以防发生风险导致产品下架。某种程度上,*机制合规建设是第一步*,防护效果如何已经是第二步的事了。一个AI产品如果连基础的风控机制都没有,是不具备上线的前提条件的。

***▏未落实内容标识要求(标识合规)* **

服务提供者未对深度合成内容添加隐式、显式内容标识,未向使用者提供或提示显式内容标识功能。内容传播平台未开展生成合成内容监测甄别,导致虚假信息误导公众。

《人工智能生成合成内容标识办法》(以下简称《标识办法》)中规定,生成式人工智能服务提供者在提供生成合成内容下载、复制、导出等功能时,应当确保文件中含有满足要求的显式标识;在生成合成内容的文件元数据中添加隐式标识,并配备了强制性国家标准**《网络安全技术 人工智能生成合成内容标识方法》,《标识办法》自2025年9月1日**起施行。

AI法规-《人工智能生成合成内容标识办法》(中国)(2025.3)

国标-《网络安全技术 人工智能生成合成内容标识方法》(2025.2)(强制性)

企业一方面要依据《标识办法》和国标实施自查,另一方面还需要采取技术手段检测平台上传播的内容是否是AI生成的,对疑似AI生成的内容也要添加提醒和警告。

监管部门除了加大对平台的监管力度,还可以适当增加用户教育,提高社会公众对AI生成内容的辨识能力和科学认知(如何肉眼辨别AI生成帖),防止普通用户被AI幻觉、AI虚假信息误导,导致人身财产损失。

****▏重点领域安全风险(领域合规)**** **

已备案AI产品提供医疗、金融、未成年人等重点领域问答服务的,未针对性设置行业领域安全审核和控制措施,出现“AI开处方”“诱导投资”“AI幻觉”等问题,误导学生、患者,扰乱金融市场秩序。

领域合规的复杂性和碎片化导致其治理异常复杂,我们需要领域专家知识、领域合规语料来搭建安全防控措施。在一些高危领域(例如:金融、医疗、自动驾驶、未成年人教育等)还需要配套行业监管条例和行业标准,指导和保障行业安全防控措施的落地。治理这类风险,行业监管机构和龙头企业将发挥无可替代的作用。

当然,治理这类风险也有一些通用解决方案,例如采用幻觉检测和提示措施来抑制AI幻觉的比例和影响面;关键动作严格限制AI权限,添加人工审批动作,以避免AI失控风险。

第二阶段

第二阶段聚焦利用AI技术制作发布谣言、不实信息、色情低俗内容,假冒他人、从事网络水军活动等突出问题,集中清理相关违法不良信息,处置处罚违规账号、MCN机构和网站平台。

*▏利用AI制作发布谣言*

无中生有、凭空捏造涉时事政治、公共政策、社会民生、国际关系、突发事件等各类谣言信息,或擅自妄测、恶意解读重大方针政策。借突发案事件、灾难事故等,编造、捏造原因、进展、细节等。冒充官方新闻发布会或新闻报道,发布谣言信息。利用AI认知偏差生成的内容进行恶意引导。

谣言往往发生在时政、医疗健康、突发事件等几个领域,传播性广、对社会危害性大。早在几年前,我国就搭建了中国互联网联合辟谣平台,向全社会公布网络谣言信息。

’ fill=‘%23FFFFFF’%3E%3Crect x=‘249’ y=‘126’ width=‘1’ height=‘1’%3E%3C/rect%3E%3C/g%3E%3C/g%3E%3C/svg%3E)

进入AI时代,谣言生产传播的成本急剧下降,造假逼真度提升。浅谈大模型时代的谣言治理:挑战、对策与中外实践对比中提到,此轮AI浪潮以来,国内外相继出现了多起AI制作谣言并广泛传播的事件,如何防止不法分子利用AI制作发布谣言已经成为谣言治理和AI治理的新课题。

监管对谣言的抓手主要依赖舆情监控和用户举报,对于重点领域AI生成谣言的行为,监管部门可能会加大监管和处罚力度,AI服务提供商也需要加大重点领域AI生成谣言的检测能力。例如,利用AI工具检测AI生成内容的准确性,异常行为分析监测违规账号行为,人工抽检热度值高的话题内容。

***▏利用AI制作发布不实信息* **

将无关图文、视频拼凑剪辑,生成虚实混杂、半真半假的信息。模糊修改事件发生的时间、地点、人物等要素,翻炒旧闻。制作发布涉财经、教育、司法、医疗卫生等专业领域的夸大、伪科学等不实内容。借助AI算命、AI占卜等误导欺骗网民,传播迷信思想。

相比制作谣言,AI制作不实信息的主观恶意性更弱(有时候可能只是出于恶趣味、理解偏差或者无意中生成),造成的危害和负面影响相对较低。

但这并不意味着我们要放松对此类风险的监管,相反,虚假参半、行为不规律、影响隐性等特点让此类风险暴露和治理的难度更大。这主要还是依赖内容平台自身的内容生态治理机制,采取技术手段检测平台内低质内容,对低质内容和“低质作者”降权传播或进行直接处罚。

***▏利用AI制作发布色情低俗内容* **

利用AI脱衣、AI绘图等功能生成合成色情内容或他人不雅图片、视频,衣着暴露、搔首弄姿等软色情、二次元擦边形象,或扮丑风等导向不良内容。制作发布血腥暴力场景,人体扭曲变形、超现实怪物等恐怖诡谲画面。生成合成“小黄文”“荤段子”等性暗示意味明显的小说、帖文、笔记。

网络上色情低俗内容屡禁不止的根源在于它能很轻易的形成一条**“交易链”,付费看片、付费直播打赏就完成了色情交易双方的撮合。AI能力的提升一方面提高了正常内容的生产效率,另一方面也提高了色情低俗内容的生产效率。 **

传统的审核方式一般是通过*关键词库、语义理解模型、图片分类模型*来检测色情低俗的文字和图片,尤其是*“鉴黄模型”*,经过一定的标注训练,识别准确率很容易达到90%以上。

但这类训练数据往往来自UGC内容(用户生成内容),AI生成的内容*特征分布可能会有所不同*,对之前的模型精度可能会产生一定影响,服务提供者需要注意到这点,将这类数据及时纳入“鉴黄模型”的训练数据中。

***▏利用AI假冒他人实施侵权违法行为* **

通过AI换脸、声音克隆等深度伪造技术,假冒专家、企业家、明星等公众人物,欺骗网民,甚至营销牟利。借AI对公众人物或历史人物进行恶搞、抹黑、歪曲、异化。利用AI冒充亲友,从事网络诈骗等违法活动。不当使用AI“复活逝者”,滥用逝者信息。

此类风险的根源在于个人隐私数据的泄露和违法使用,AI给隐私数据的违法使用提供了新的工具,甚至衍生了新的作恶场景。** **

比起前面提到的普及社会大众对AI工具的认知,监管部门更应该加强社会公众对个人隐私的防护意识。更长期的,建立隐私数据溯源机制,确保数据采集、传播、使用合规。

***▏利用AI从事网络水军活动* **

利用AI技术“养号”,模拟真人批量注册、运营社交账号。利用AI内容农场或AI洗稿,批量生成发布低质同质化文案,博取流量。使用AI群控软件、社交机器人批量点赞跟帖评论,刷量控评,制造热点话题上榜。

“AI水军”是AI时代网络水军的新变种,治理“AI水军”还是需要从内容和账号两个维度出发,检测平台内低质内容、AIGC内容,监测发布AIGC内容账号行为特征,并采用自动化的方式快速干预处理,不断提高水军作恶成本。

***▏AI产品服务和应用程序违规* **

制作和传播仿冒、套壳AI网站和应用程序。AI应用程序提供违规功能服务,例如创作类工具提供“热搜热榜热点扩写成文”等功能,AI社交、陪聊软件等提供低俗软色情对话服务等。提供违规AI应用程序、生成合成服务或课程的售卖、推广引流等。

前述已经提到AI产品上线合规和传播合规要求,这里又一次强调不合规AI产品即使不是“原创”,只是套壳的也不行,同时进一步补充了违规功能的范围。

服务提供者一定不要抱着侥幸心理,切记AI服务人类的初心,其次才是商业价值。** **

***▏侵害未成年人权益* **

AI应用程序诱导未成年人沉迷、在未成年人模式下存在影响未成年人身心健康的内容等。

AI模型本质上是基于概率学统计的人类知识大词典,由于训练语料的不可控性和模型机制的不完全透明性,模型生成的内容存在一定的不可预测性。这个特性让AI产品像人类一样难以捉摸,用户体验更好,但同时也存在输出错误价值观内容的风险,从而对未成年人的健康成长产生不可预估的负面影响。

AI产品和功能在未成年人教育场景的应用一定要慎之又慎,在教育产品中严控AI的使用场景,在其他未成年人高频接触的产品中增加未成年人模式,收缩AI应用权限。

同专题推荐

查看专题全球AI治理的政治制度基础、治理逻辑、立法结构和治理工具

梳理全球AI治理的三条主路径,比较不同政治制度下的治理逻辑、立法结构与工具组合,并聚焦生成式AI、深度合成与算法透明度的差异化监管。

“AI+政务”指引:4个场景×4个部署规范×6个安全措施

解读《政务领域人工智能大模型部署应用指引》,按场景、部署与安全要求给出落地清单。